Facebook usará Inteligencia Artificial para combatir noticias falsas y peligrosas

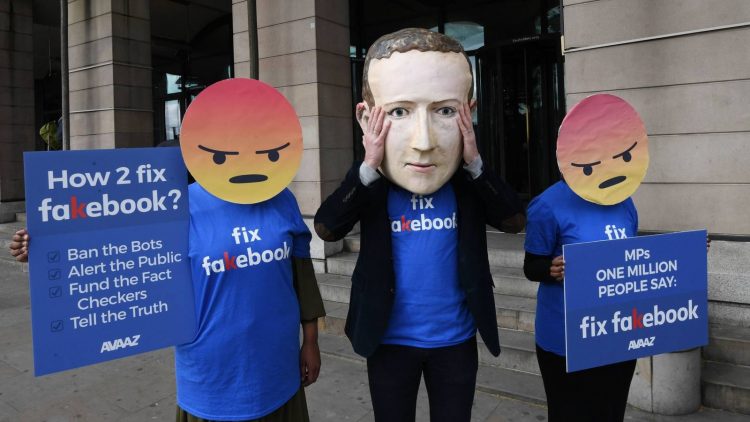

Facebook ha sido objeto de duras críticas el año pasado por parte de personas que dicen que la compañía no está haciendo lo suficiente para detener el discurso de odio, el acoso en línea y la difusión de noticias falsas.

Para ser justos, la tarea de vigilar las actividades de 1,62 mil millones de usuarios diarios que generan 4 petabytes de datos, incluidas 350 millones de fotos, por día no es una tarea pequeña. No es fácil ser la plataforma social más grande del mundo.

Aún así, la compañía ha sido criticada por permitir que decenas de grupos motivados por el odio difundan publicaciones ofensivas y amenazantes y por permitir que grupos conspiracionistas y de ultraderecha, como QAnon, difundan libremente acusaciones políticas falsas. Los análisis académicos y gubernamentales de las elecciones presidenciales de 2016 revelaron evidencia de interferencia masiva por parte de actores nacionales y extranjeros, y parece que también se realizaron esfuerzos similares en las elecciones de 2020.

Facebook emplea a 15.000 moderadores de contenido para revisar informes de mala conducta que van desde subterfugios políticos hasta acoso, amenazas “terroristas” y explotación infantil. Por lo general, han abordado los informes cronológicamente, y con frecuencia permiten que las acusaciones más graves no se aborden durante días mientras se revisan los problemas menores.

El viernes, Facebook anunció que incorporará el aprendizaje automático al proceso de moderación. Utilizará algoritmos para detectar los problemas más graves y asignárselos a moderadores humanos. Los moderadores de software continuarán manejando el abuso de bajo nivel, como la infracción de derechos de autor y el spam.

Facebook dice que evaluará las publicaciones problemáticas según tres criterios: viralidad, gravedad y probabilidad de que estén violando las reglas. Una publicación llena de obscenidades que amenace con violencia en el sitio de disturbios raciales, por ejemplo, tendría la máxima prioridad, ya sea eliminada automáticamente por una máquina o asignada a un moderador para evaluación y acción inmediatas.

“Todas las violaciones de contenido … aún reciben una revisión humana sustancial”, dijo Ryan Barnes, gerente de producto del equipo de Integridad de la comunidad de Facebook. “Usaremos este sistema para priorizar mejor el contenido. Esperamos usar más automatización cuando la infracción del contenido sea menos grave, especialmente si el contenido no es viral”.

Facebook ha sido acusado de mal manejo de cuentas durante disturbios recientes de alto perfil. En un caso, la compañía fue demandada luego de tiroteos mortales en Kenosha, Wisconsin, en el marco de las protestas contra los oficiales de policía que hirieron gravemente a un hombre negro luego de dispararle cuatro tiros en la espalda durante un arresto. La demanda alega que Facebook no eliminó las páginas de los grupos de odio involucrados en los tiroteos de los vigilantes.

Durante la pandemia del año pasado, un estudio realizado por una organización sin fines de lucro encontró 3.8 mil millones de visitas en Facebook en el contenido engañoso relacionado con COVID-19.

A veces, las críticas son provocadas por moderadores de Facebook demasiado cautelosos. En junio pasado, el periódico The Guardian se quejó de que los lectores que intentaban hacer circular una foto histórica que publicó fueron advertidos y bloqueados por Facebook. La imagen de hombres aborígenes casi desnudos encadenados en Australia Occidental, tomada en la década de 1890, fue publicada luego de que Scott Morrison, el primer ministro australiano, dijera que su país nunca se involucró en la esclavitud. Morrison se retractó de sus comentarios luego de la publicación del artículo y la foto. Posteriormente, Facebook se disculpó por clasificar incorrectamente la foto como desnudez inapropiada.

Los funcionarios de Facebook dicen que la aplicación del aprendizaje automático es parte de un esfuerzo continuo para detener la propagación de información peligrosa, ofensiva y engañosa, al tiempo que se garantiza que las publicaciones legítimas no sean censuradas.

Un ejemplo de los desafíos que enfrenta Facebook fue la creación virtual de la noche a la mañana de un grupo de protesta masivo que impugna el conteo de las elecciones de 2020. Un grupo de Facebook que exigía un recuento obtuvo 400.000 miembros en tan solo unos días. Facebook no ha bloqueado la página.

Si bien no hay nada ilegal en solicitar un recuento, una ola de información errónea sobre presuntos abusos en la votación, cargos que han sido descartados categóricamente por funcionarios en los 50 estados, tanto republicanos como demócratas, es un recordatorio preocupante del potencial de información falsa para moldear opiniones políticas.

“El sistema debe lograr un equilibrio entre la IA y los revisores humanos para cometer errores menos graves”, dijo Chris Palow, miembro del equipo de Integridad de Facebook. Y terminó afirmando algo muy importante, que se olvida justo porque la difusión de la información sobre ciencia y tecnología es idealista y exagerada; “La IA nunca será perfecta”.

Con información de TechXplore y Phys.org| Traducción y edición del Colectivo Alterius

Sin comentarios