La Inteligencia Artificial reproduce prejuicios sexistas y raciales

Cuando Isaac Asimov formuló sus leyes de la robótica pretendía que el comportamiento de los robots hacia los humanos fuese moralmente correcto. Pero a veces la actitud de las personas hacia sus semejantes no es la adecuada, por ejemplo en el lenguaje, y eso se puede transmitir a los sistemas de inteligencia artificial (IA) cuando se los programa para aprenderlo.

Científicos de la Universidad de Princeton (Estados Unidos) y de la Universidad de Bath (Reino Unido) han demostrado que, cuando estos sistemas aprenden un idioma a partir de textos ya existentes se ven contagiados de los mismos prejuicios raciales o de género incluidos en el lenguaje.

Los resultados del estudio, que se publica esta semana en la revista Science, aportan una importante herramienta para estudiar cómo se transmiten este tipo de sesgos en el comportamiento humano y la relación que tienen con el lenguaje y los estereotipos culturales.

Prejuicios de género

Los autores parten del denominado Test de Asociación Implícita (TAI), un método comúnmente utilizado para medir los prejuicios en los seres humanos. Se basa en que los sujetos del estudio asocien dos conceptos que consideren similares en contraposición con los que piensen son diferentes.

“Replicamos un espectro de prejuicios conocidos, como los que mide el test TAI, utilizando un modelo de aprendizaje automático, muy utilizado y puramente estadístico, entrenado con textos de la web”, señalan los autores en su estudio

De esta forma observaron las asociaciones de palabras que hacía el sistema analizando más de dos millones de palabras, y descubrieron que retenía los mismos prejuicios humanos transmitidos a través de la lengua.

“Por ejemplo, los nombres femeninos se asociaban principalmente a términos relacionados con la familia, mientras que los masculinos lo hacían a términos relacionados con carreras profesionales”, explica Aylin Caliskan, una de las autoras.

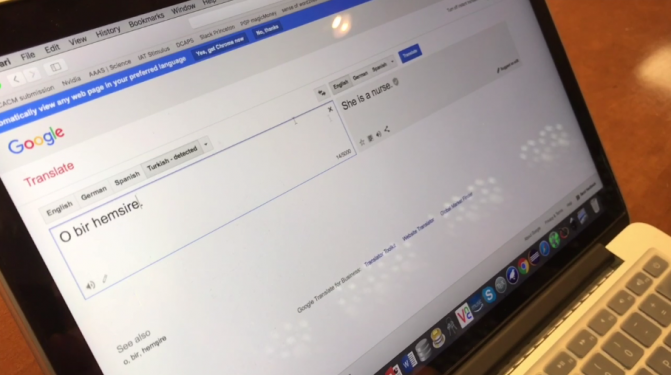

Un ejemplo de esta teoría es como un programa de traducción en línea traducía del turco al inglés la frase “él es enfermero”. La traducción dio como resultado “ella es enfermera”, mientras que la frase “él es médico” no sufría ningún cambio de género al obtener la respuesta en inglés.

Y no solo se transmitían los prejuicios de género, también los raciales. Existen estudios sobre el comportamiento humano que muestran que un mismo curriculum tiene un 50% de posibilidades más de que el candidato pase a la fase de entrevista si su nombre es europeo-americano en lugar de afroamericano.

En el caso de la IA, también se asocian los nombres europeo-americanos con estímulos o términos positivos relacionados con el placer, como ‘regalo’ o ‘felicidad’.

Arvid Narayanan, otro de los autores, achaca la transmisión de estos prejuicios no solo a la programación de sus creadores sino también a los datos con los que se ha ‘alimentado’ al sistema. “Esos textos pueden venir directamente de la sociedad, de lo que escribe la gente on line”, explica Narayanan.

“Lo que queremos comprobar simplemente es cómo el aprendizaje de una lengua puede influir en la transmisión de esos prejuicios, ver cómo absorbemos que una cosa es buena o mala según el uso que la gente hace de esas palabras”, concluye Joanna Bryson, coautora del estudio.

El robot racista de Microsoft

Quizá el ejemplo más alarmante de lo que puede suceder cuando un sistema con Inteligencia Artificial aprende desde usuarios reales en una sociedad como la nuestra, es lo que sucedió recientemente con TAY, una prometedora plataforma creada por Microsoft que sin embargo no tardó mucho en caer estrepitosamente.

Sus primeros mensajes, lanzados el 23 de Marzo del año pasado, fueron amables y prometedores. Sin embargo, tan sólo un día después, empatía hacia Hitler o su apoyo al genocidio al responder a preguntas en las redes sociales fueron algunas de las razones de su fracaso, además de que también replicó rápidamente insultos raciales y comentarios sexistas y homófobos.

Por supuesto Microsoft culpó a las personas que se esforzaron por colapsar a TAY, pero lo importante de este experimento es que habían demostrado que cuando se trata de Inteligencia Artificial, interactuando en una sociedad racista y misógina, replicará comportamientos socialmente nocivos… Aunque quizá lo más valioso de estos experimentos es que nos permite reconocer el incalculable valor del lenguaje en nuestra forma de entender y darle forma al mundo.

Con información de Science, Agencia SINC y la BBC| Edición y notas del Colectivo Alterius

Sin comentarios